언어 모델의 평가

모델을 설계할 때 가장 중요한 것 중 하나는 '모델을 어떻게 평가할 것인가'이다. 이에 맞게 테스트셋을 구축하고 테스트셋에 대한 평가 지표를 체계적으로 설계함으로써 원하는 태스크에 대한 모델의 성능을 적절하게 평가할 수 있다.

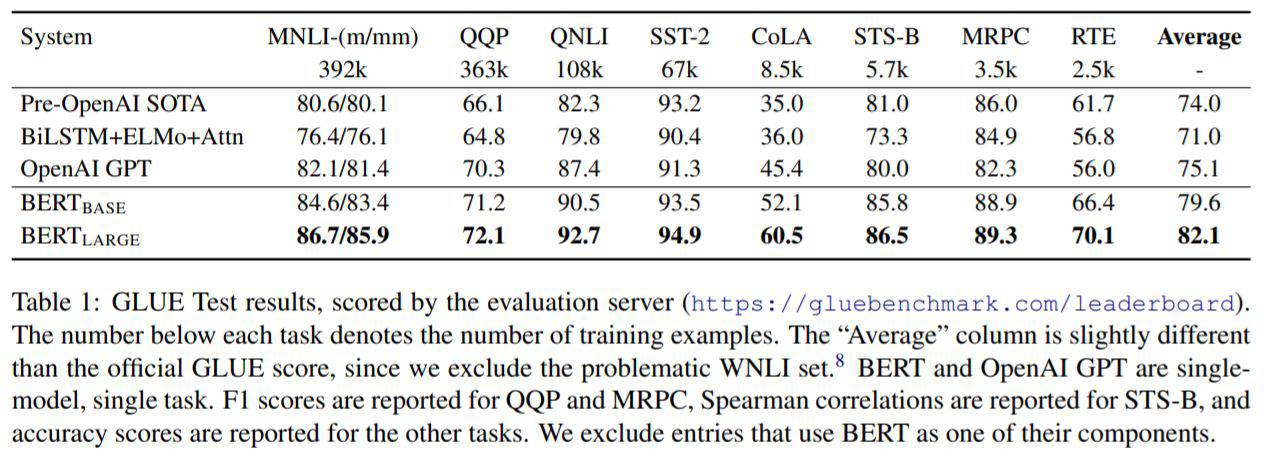

평가 방법이 비교적 명확하고 표준화 되어 있는 CV와는 달리 NLP의 경우에는 언어와 태스크에 따른 모델 평가 방법이 제대로 표준화되어 있지 않았다. 2019년 BERT 페이퍼가 발표되면서 GLUE benchmark가 등장하였고, 이는 현재 영어 관련 NLP 태스크 평가 방법의 표준이 되었다.

GLUE 벤치마크 (General Language Understanding Evaluation)

- Quora Question Pairs (QQP, 문장 유사도 평가)

- Question NLI (QNLI, 자연어 추론)

- The Stanford Sentiment Treebank (SST, 감성 분석)

- The Corpus of Linguistic Acceptability (CoLA, 언어 수용성)

- Semantic Textual Simiilarity Benchmark (STS-B, 문장 유사도 평가)

- Microsoft Research Paraphrase Corpus (MRPC, 문장 유사도 평가)

- Recognizing Textual Entailment (RTE, 자연어 추론)

- SQUAD 1.1 / 2.0 (질의응답)

- MultiNLI Matched (자연어 추론)

- MultiNLI Mismatched (자연어 추론)

- Winograd NLI (자연어 추론)

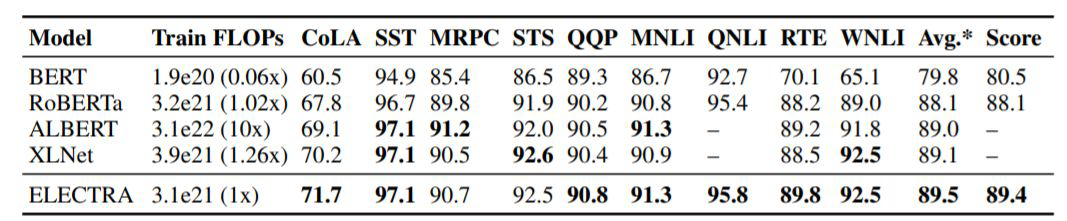

→ 이러한 평가체계의 표준화를 통해 BERT 이후 등장한 모델들(ALBERT, ELECTRA, RoBERTa, ...)이 더 좋은 성능임을 효과적, 효율적으로 입증할 수 있게 되었다. (아래 표 참고)

GLUE for Generation Models

이전까지는 자연어 이해 모델에 대한 이야기. GLUE를 통해 자연어 생성 모델의 평가도 수행할 수 있다.

자연어 이해 이외에도 자연어 생성 분야에서도 BERT와 같은 pre-trained & fine-tune downstream task 구조가 효과적이었음을 보여준 연구가 등장하였다.

→T5, BART (여기에서는 인코더 부분보단 디코더 부분에 대한 학습 위주! 생성모델이므로 생성이 이루어지는 디코더가 더 중요하다)

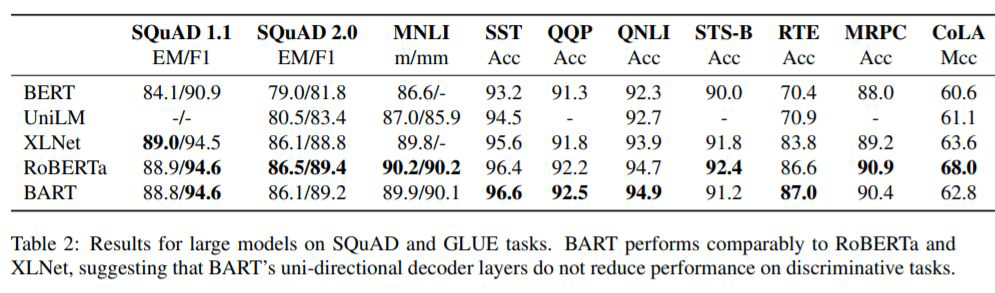

아래 그림과 같이, BART는 생성 이외에도 자연어 이해에도 탁월함을 보여주기 위해 자연어 이해 모델 관련 평가 지표를 측정해서 비교해준다.

KLUE (for Korean)

GLUE는 영어에만 적용되기 때문에 각 언어에 따라 FLUE(프랑스어), CLUE(중국어) 등 다양한 언어의 벤치마크가 등장하였다. 한국어의 경우에는 upstage에서 KLUE라는 벤치마크를 구축하였다. KLUE가 포함하고 있는 태스크는 다음과 같다.

- 개체명 인식 (Named Entity Recognition)

- 품사 태깅 및 의존 구문 분석 (POS tagging + Dependency Parsing)

- 문장 분류 (Text classification)

- 자연어 추론 (Natural Language Inference)

- 두 개의 문장이 있을 때 이 두 개의 문장이 모순 관계에 있는지 등의 문장 간의 관계를 파악하고자 하는 것 - 문장 유사도 (Semantic Textual Similarity)

- 관계 추출 (Relation Extraction)

- Entity가 2개 등장했을 때 둘 간의 관계를 맞힘. (Text에서 지식 그래프 등의 정제되어 있는 데이터 구조를 추출해낼 수 있다는 것) - 질의 응답 (Question & Answering)

- 질문이 들어왔을 때 그를 이해하고, 그에 대한 답이 지문 내 어디에 위치해 있는지 span을 예측하는 task - 목적형 대화 (Task-oriented Dialogue)

- 두 사람의 대화 패턴을 이해하고 유의미한 정보를 추출해냄.

ex) 전화로 레스토랑 예약을 하는 시나리오 → 여기에서 예약하고자 하는 메뉴, 인원, 시간 등을 이해하고 추출해내는 task (문장이나 document가 아니라 대화 데이터라는 점)